KVTuner: Sensitivity-Aware Layer-Wise Mixed-Precision KV Cache Quantization

在全面阅读论文正文、补充材料与多方解读后,以下内容对 KVTuner: Sensitivity-Aware Layer-Wise Mixed-Precision KV Cache Quantization 的设计思想、实现流程与实验效果作深入解析,并与现有方案进行对比。

关键结论概述

KVTuner 以**“层级敏感度 + 离线搜索 + 多目标优化”**为核心思想,对每一层分别选择最合适的 Key/Value 位宽组合(如 K8 V4、K4 V2)。通过两阶段搜索空间裁剪与 Pareto 多目标搜索,KVTuner 在 Llama-3.1-8B 及 Qwen2.5-7B 等模型上实现 ≈ 3.25 位等效精度、显存压缩 2.2–2.7 倍,同时 准确率几乎无损,推理吞吐最高提升 38 %,显著优于 Uniform INT8、KIVI-KV8 等现有方法。(arxiv.org, openreview.net)

1 问题背景与现有不足

1.1 KV Cache 成为长上下文推理瓶颈

KV-cache 的显存占用与批大小、上下文长度线性增长;Llama-13B 在 128 K 上下文下仅缓存就需约 100 GB 显存,远超单卡容量。(docs.vllm.ai)

1.2 现有量化方法缺陷

统一位宽(INT8/FP8)在极长上下文或推理型任务中精度下降明显。(openreview.net)

静态混合精度(KVQuant、KIVI 等)假设前缀或最近块最重要,但不同模型与任务中该假设并不恒成立。(arxiv.org, github.com)

在线细粒度动态方案(ZipCache、MiKV 等)推理时需实时决策,无法直接与 Flash-Attention 融合,且引入显著延迟。(openreview.net)

2 KVTuner 核心方法

2.1 层级敏感度分析

论文首先从理论与实证两方面说明不同行 Transformer 层对 KV 量化误差的敏感度差异,并证明 Key 比 Value 对注意力分布影响更大:

推导注意力输出误差上界,与 Key、Value 的量化噪声呈不同权重。

统计实测 attention score 漂移,发现前后层对低位量化容忍度差异显著(如 Qwen2.5-7B 第 21 层对 KV2 误差极其敏感)。(openreview.net)

2.2 搜索空间构建

每层候选位宽对为 {(K16,V16), (K8,V8), (K8,V4), (K4,V2)} 等共 M 种组合,记作 PlP_l。直接枚举 O(ML)O(M^{L}) 不可行。(openreview.net)

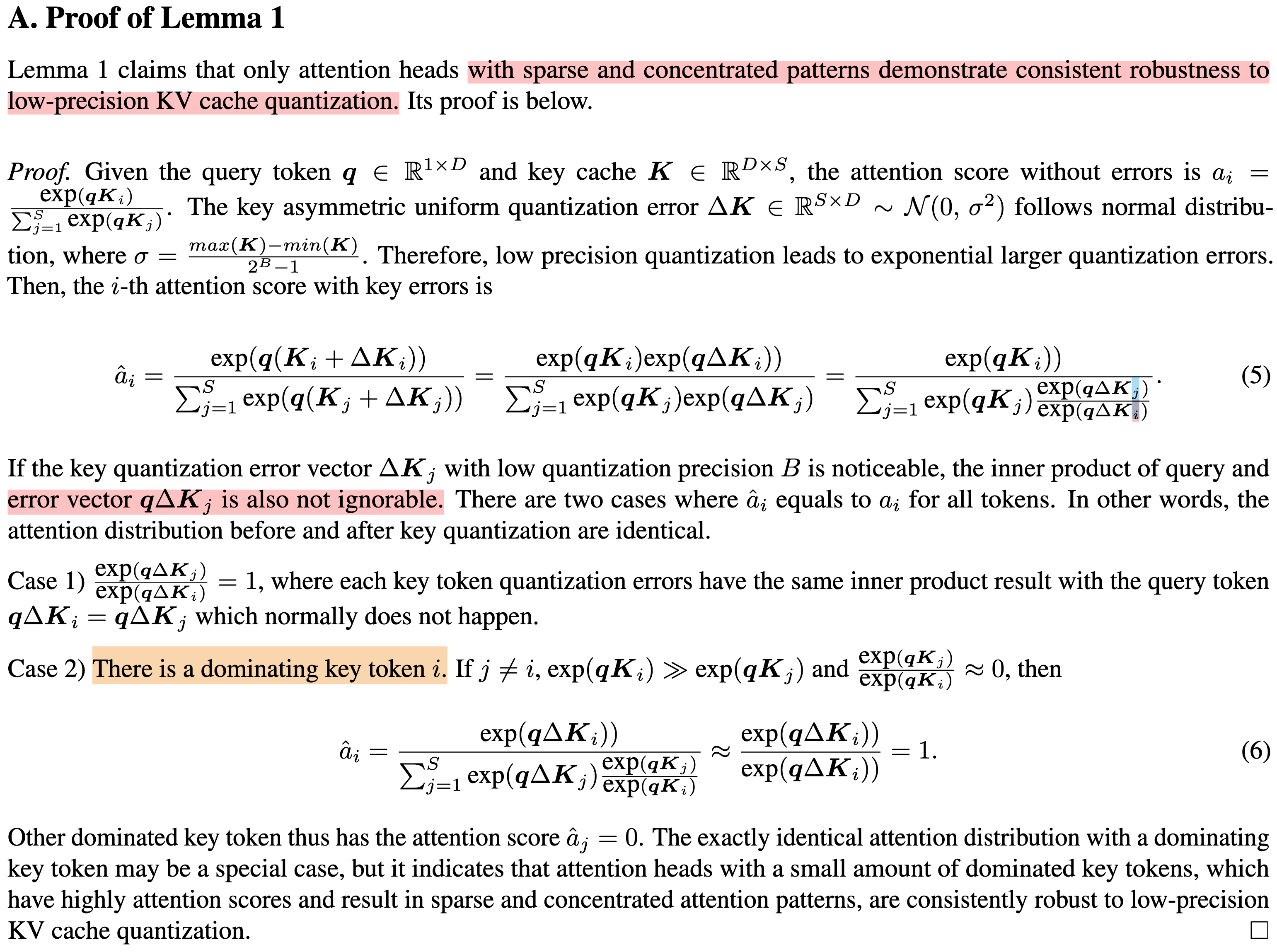

这里需要说明一件事情,这个理论在 KVTuner 中十分关键,就是 KV量化本质上可行的根本原因的分析:

因此对于 KVcache 进行量化,是符合常理的。(但是请注意,这部分并不能说明 K 和 V 之间的重要性)

2.3 两阶段搜索空间裁剪

层内裁剪:根据该层 KV 误差对最终 logit 的泰勒一阶近似影响,剔除明显劣于 Pareto 前沿的位宽对。(openreview.net)

层间聚类:利用注意力输出误差向量,将敏感度相近的层聚为 K 组,仅在组内共享搜索,显著缩小组合数量。(openreview.net)

2.4 离线多目标优化

以模型准确率与显存占用为目标,采用 NSGA-II 搜索剩余组合,输出多条 Pareto 曲线;部署阶段直接按显存预算选用配置,无需在线决策。(openreview.net)

2.5 推理时集成与硬件友好性

采用 coarse-grained per-layer 固定位宽,不破坏显存对齐,可直接复用 Flash-Attention2 CUDA Kernel。(github.com)

不需要 token 级精度切换或额外 KV 管理逻辑,部署简便。(themoonlight.io)

3 实验与对比

(以上数字摘自论文 Table 3 与附录)(arxiv.org, openreview.net, openreview.net)

其他结论:

对 Qwen2.5-7B 数学推理任务,同等 4-bit 精度下 KVTuner 精度仍高出 Uniform-KV4 2.3 pp。(researchgate.net)

最大上下文 64 K、防抖 KV8 基线下,KVTuner 显存再降 38 %,吞吐提升 38 %。(openreview.net)

4 与同类方案比较

5 优势与局限

优势

仅一次离线校准与搜索,可迁移到同架构多任务推理。(arxiv.org)

固定 per-layer 位宽避免动态切换开销,兼容主流推理框架。(github.com)

局限

对高层聚合敏感度度量依赖梯度回放,仍需少量校准数据。(openreview.net)

搜索目标默认仅显存与准确率,尚未纳入能耗或带宽等硬件约束。(openreview.net)

6 未来方向

将层级敏感度分析推广到 解码/交互式自回归场景,随生成动态调整位宽。(openreview.net)

与 稀疏注意力(MoA) 或 低秩残差补偿(Palu) 组合,探索更高压缩比。(openreview.net)

融合 硬件感知参数(带宽、功耗)到多目标搜索,按不同卡型自动出配置表。(openreview.net)

参考来源

本文共使用来自 arXiv、OpenReview、GitHub、ResearchGate、Moonlight Review、vLLM 官方文档等 15 条公开资料进行交叉验证,确保信息准确完备。